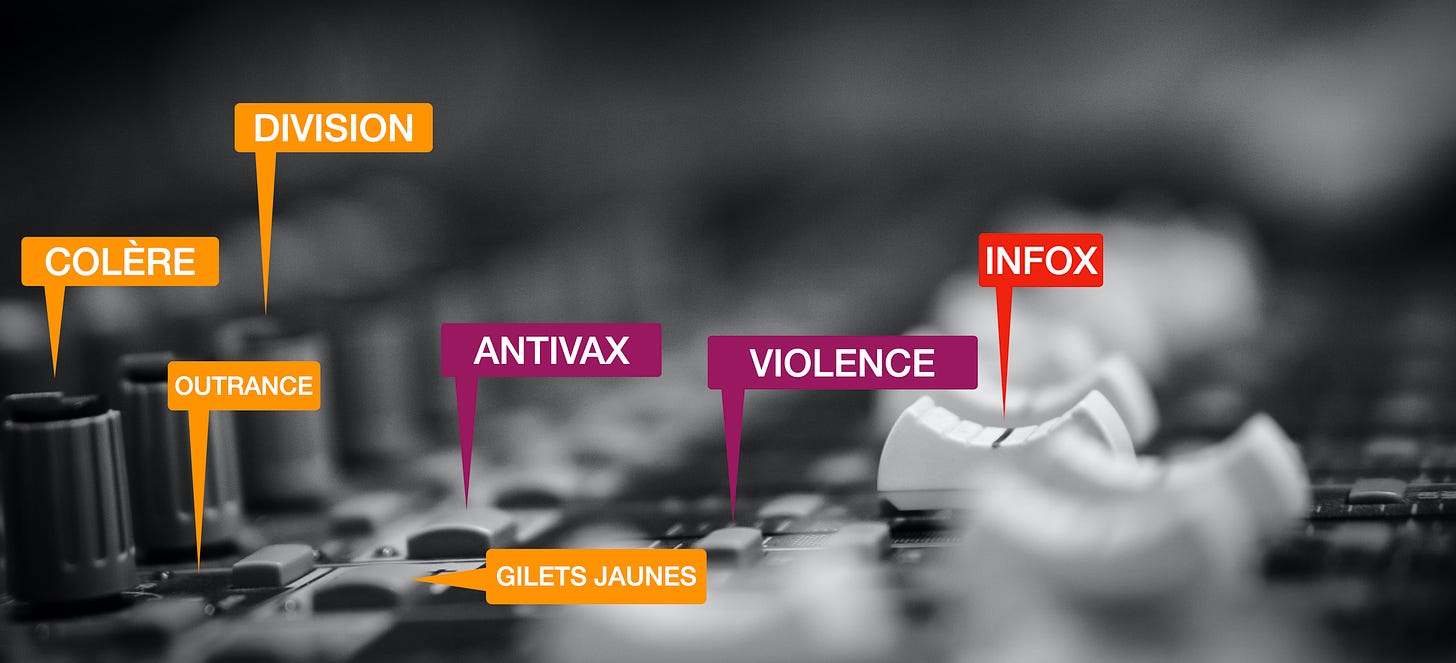

La terrifiante table de mixage de Facebook pour contrôler et monétiser l’opinion

Avec cynisme et technicité, le réseau social a créé tous les instruments pour façonner l’opinion. Et il n’a pas l’intention d’en faire un usage modéré.

L’idée du projet Amplify remonte au mois de janvier dernier et résulte d’un vaste brainstorming de Facebook pour contrer son image de plus en plus dégradée. Le programme, détaillé par le New York Times cette semaine, met une nouvelle fois en lumière la façon dont le réseau social peut contrôler l’opinion à volonté.

En l’espèce, il s'agissait de donner au fil d’infos de Facebook une coloration plus favorable à l’entreprise elle-même. La technique consistait tout simplement à saupoudrer le News Feed, regardé chaque jour par 1,9 milliard d’individus, d’informations positives sur les actions entreprises par Facebook pour corriger ses déviances tandis que de la publicité ciblée renvoyait vers des articles plus détaillés créés pour la circonstance.

Il s’agissait en somme d’une campagne de communication subliminale, où tout ce qui pouvait donner une image favorable du réseau social se trouvait sur-représenté dans le News Feed.

Le programme a été débranché récemment sans justification évidente, autre qu’une contestation interne palpable. Nul ne sait vraiment si Amplify a pu améliorer la perception de Facebook. Mais quand on connaît la précision de son ciblage, il est vraisemblable qu’une part importante de l’opinion a été sensible aux arguments pro-Facebook distillés dans le cadre du projet.

A la limite, peu importe : l’impression de malaise persiste sur la capacité de Facebook à injecter ce que bon lui semble dans le News Feed à l’insu du public. L’équipe dirigeante du réseau social a démontré qu’elle n’avait plus aucune inhibition dans ce domaine.

Elle avait déjà franchi quelques étapes décisives dans le cynisme avec l’encadrement algorithmique du News Feed qui reste l’épine dorsale du système Facebook.

Le News Feed est un vaste filtre destiné à gérer la cataracte d’interactions dont chacun est potentiellement destinataire, qu’il s’agisse de photos d’amis ou de famille, d’un commentaire, ou du partage d’un article, d’une vidéo ou d’un contenu original.

Chaque personne a en moyenne 340 amis sur Facebook dont à peu près un quart sont considérés comme “proches”. C’est une moyenne avec des écarts gigantesques en termes d’activité et donc d’influence.

Sur Facebook, la nature des liens diffère considérablement de la vie réelle. Dans le monde physique, la proximité est fonction d’une série de facteurs tels que l’affinité intellectuelle, une convergence sur des valeurs et des opinions, même si le plaisir d’une discussion contradictoire est un facteur d’attractivité. Mais des liens naissent aussi les hiérarchies. Une vague relation peut devenir quasi infréquentable et disparaître progressivement du champ social d’un individu, soit naturellement, soit par une action délibérée.

Ce n’est pas le cas sur Facebook où les vociférations de l’ancien pote insupportable devenu Trumpiste lui garantissent une visibilité persistante dans le News Feed.

Les savants curseurs du MSI

Pour quantifier tout cela, Facebook a conçu un système baptisé MSI pour Meaningful Social Interaction.

Sous cette apparence d’innocuité se cache l’aspect le plus sinistre du mode opératoire de Facebook pour accentuer et monétiser les pires traits de la société.

Le MSI est en fait un indice qui mesure la propagation d’un contenu selon des règles précises. Celles-ci ont été révélées dans une longue et dévastatrice enquête du Wall Street Journal, les Facebook Files.

Selon cette classification, chaque interaction sur un contenu génère une note qui va donner au contenu sa qualité —du point de vue de Facebook s’entend. Un “Like” sur une photo de famille vaudra 1 point ; un clic sur le bouton “colère” pour qualifier un fait d'actualité en vaudra 5. Mais si l’utilisateur partage un contenu avec un commentaire, le score du post monte à 15 points ; et si le commentaire est particulièrement teigneux —“significant” selon la terminologie-maison — le score montera 30 points.

L’indice MSI de chaque contenu augmente évidemment avec le nombre d’interactions. Et plus le score MSI sera élevé, plus le contenu qui “porte” sera montré au plus grand nombre. C’est ainsi que vous verrez surgir dans votre News Feed les saillies de cet ancien collègue séduit par les thèses d’Eric Zemmour, dont les prises de positions sont certaines de faire exploser le MSI des milliers de fois de plus que la modération d’un Robert Badinter sur l’abolition de la peine de mort.

Sur Facebook, la nuance est l’assurance de l’inexistence.

Telle est la mécanique de propagation sur le réseau dont l’outrance et la colère sont les principaux boosters. Ceux-ci garantissent une belle monétisation puisque toute page vue comporte des bannières publicitaires sur lesquelles les utilisateurs cliquent trois fois par jour en moyenne (ce qui est énorme).

Facebook a donc un contrôle total et granulaire sur chaque News Feed. Pour réduire la propagation de contenus toxiques, il lui suffirait de jouer sur quelques curseurs du score MSI.

Mais cela réduirait l’engagement, c’est-à-dire la vitesse de propagation multipliée par le nombre d’interactions. Or l’engagement est le premier indicateur que regarde Mark Zuckerberg le matin en arrivant au bureau. Le patron de Facebook a décidé qu’il était hors de question d’y toucher, car le business en dépend. Tout comme il n’a jamais voulu réduire le nombre d’invitations qu’une personne peut envoyer dans un groupe, actuellement fixé à 2250 par jour (!!), ou encore le volume de commentaires que chacun peut laisser sur la plateforme, qui est de 300 par heure (!!!!). A eux seuls ces deux chiffres illustrent l’hallucinante capacité d'influence de Facebook — tout cela à raison de 34 minutes par jour et par personne en moyenne. D’une façon générale, toutes les tentatives destinées à limiter la toxicité de la plateforme ou à réduire sa capacité de dissémination n’ont pas abouti. C’est ainsi que la perversion algorithmique de Facebook a contré la campagne de vaccination contre le Covid avec 775 millions de posts par jour sur le sujet aux Etats-Unis, dont 41% étaient assimilables à de la propagande antivax. Une conséquence parmi mille autres.

Quelles conclusions peut-on tirer de tout cela?

1 . La contestation interne chez Facebook devient de plus en plus palpable. En témoignent les fuites dans la presse sur les pratiques de la maison. On est certes loin de la situation d’un système totalitaire s’effondrant sous l’effet de sa putréfaction interne. A 240 000 dollars par an de salaire médian, le tissu social de Facebook est plus robuste que la misère du régime soviétique.

2 . Facebook a bien plus de possibilités qu’il ne l’admet pour endiguer les contenus les plus toxiques. Seulement, toutes les mesures envisageables, dont certaines sont faciles à mettre en œuvre, entrent en conflit avec le modèle de revenu de Facebook. Par conséquent, elles sont systématiquement écartées. L’entreprise investit des fortunes dans le nettoyage de sa fosse septique, c’est indéniable, mais se prive délibérément des moyens d’en réduire l’alimentation.

3 . Les régulateurs sont perdus dans ce maelstrom. Il suffit de regarder les multiples auditions réalisées en Europe, en France, ou aux Etats-Unis. Elles sont atterrantes. Il est temps d’admettre que les autorités administratives et politiques censées protéger le public et maintenir l’intégrité de la démocratie — car c’est bien de cela ce dont il s’agit — n’ont ni les moyens, ni la compétence, ni même la volonté d’entrer dans les arcanes du système Facebook. Ce modèle de régulation, s’il persiste, est la garantie d’une inefficacité durable.

— frederic@episodiq.ues